在亚马逊云科技(AWS)2024年的re:Invent大会上,该公司展示了其在加速计算和生成式人工智能(AI)领域的最新进展。AWS通过一系列高性能、低成本的计算实例,为开发者和企业提供了构建和扩展大规模生成式AI模型的基础设施。

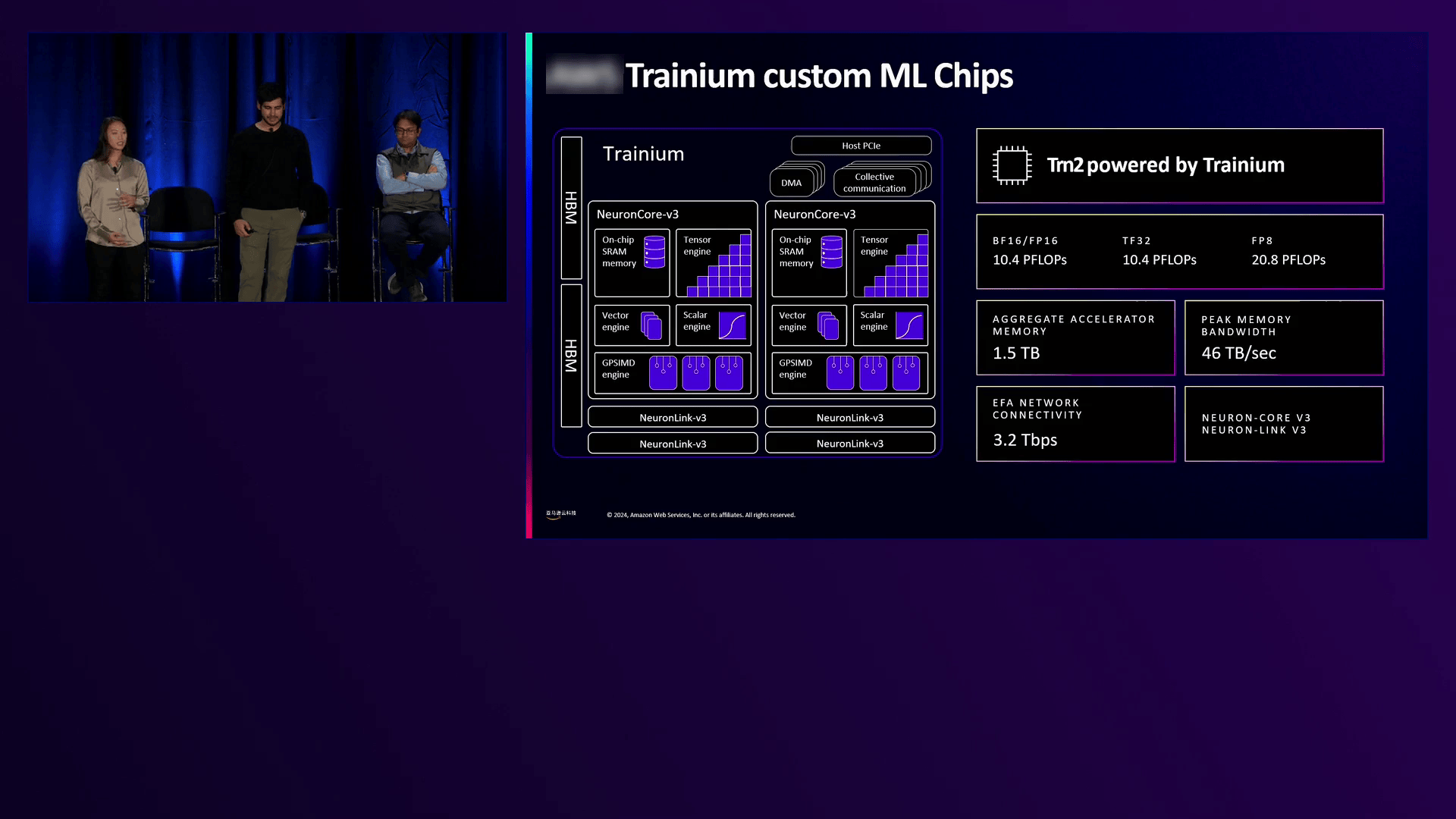

AWS宣布了一系列新功能和产品,旨在解决生成式AI工作负载的独特需求。其中,Trainium 2加速器的推出尤为引人注目。这款由AWS自主研发的AI加速器专为机器学习工作负载设计,每个加速器拥有96GB内存,支持高达1.5TB的聚合高带宽内存,为训练和推理大型模型提供了强大的计算能力。

在医疗保健领域,AWS的客户如Amgen正在利用基于Transformer的模型加速药物发现过程。这些模型能够学习蛋白质的结构和功能,为新药开发提供候选分子。大型语言模型(LLM)在简化电子病历和文档编制方面也展现出巨大潜力。

在工业和汽车制造中,生成式AI被集成到机器人技术中,提高了生产线的效率和安全性。法拉利等公司利用生成式AI设计汽车,通过高度逼真的3D渲染改善客户体验。

金融服务行业也受益于生成式AI的应用。一些公司利用LLM优化年报和财务报表的处理,使其更易于投资者理解。在零售行业,AWS推出了基于GPT的购物助手Rufus,为客户提供个性化的购物建议。

媒体和娱乐行业同样受益于生成式AI的发展。Adobe等公司利用多模态模型,使用户能够通过简单的文字输入创建复杂的电影体验。这种创新彻底改变了内容创作过程,为创作者提供了前所未有的灵活性和效率。

AWS在EC2计算层面拥有独特的优势,能够洞察生成式AI的发展趋势。过去一年中,LLM的训练规模持续增长,最大的任务使用了超过10,000个GPU进行同步分布式工作负载。AWS不断扩大其集群规模,以支持数十万个加速器的训练需求。

除了训练规模的扩大,LLM的推理需求也在全球范围内显著增长。AWS通过优化计算经济性和扩大计算足迹,使全球各地的公司都能将最强大的LLM集成到其应用程序中。

在硬件加速方面,AWS提供了包括NVIDIA GPU、Amazon Inferentia和Trainium在内的多种加速器选项。这些加速器通过高性能的芯片间互连和优化的计算资源,为AI工作负载提供了卓越的性能和成本效益。

AWS还通过其Nitro System提供了业界领先的安全功能。Nitro TPM能够测量和验证部署代码的完整性,确保应用程序运行在可信的环境中。AWS还通过优化网络协议和存储选项,提供了高效、可靠的数据访问能力。

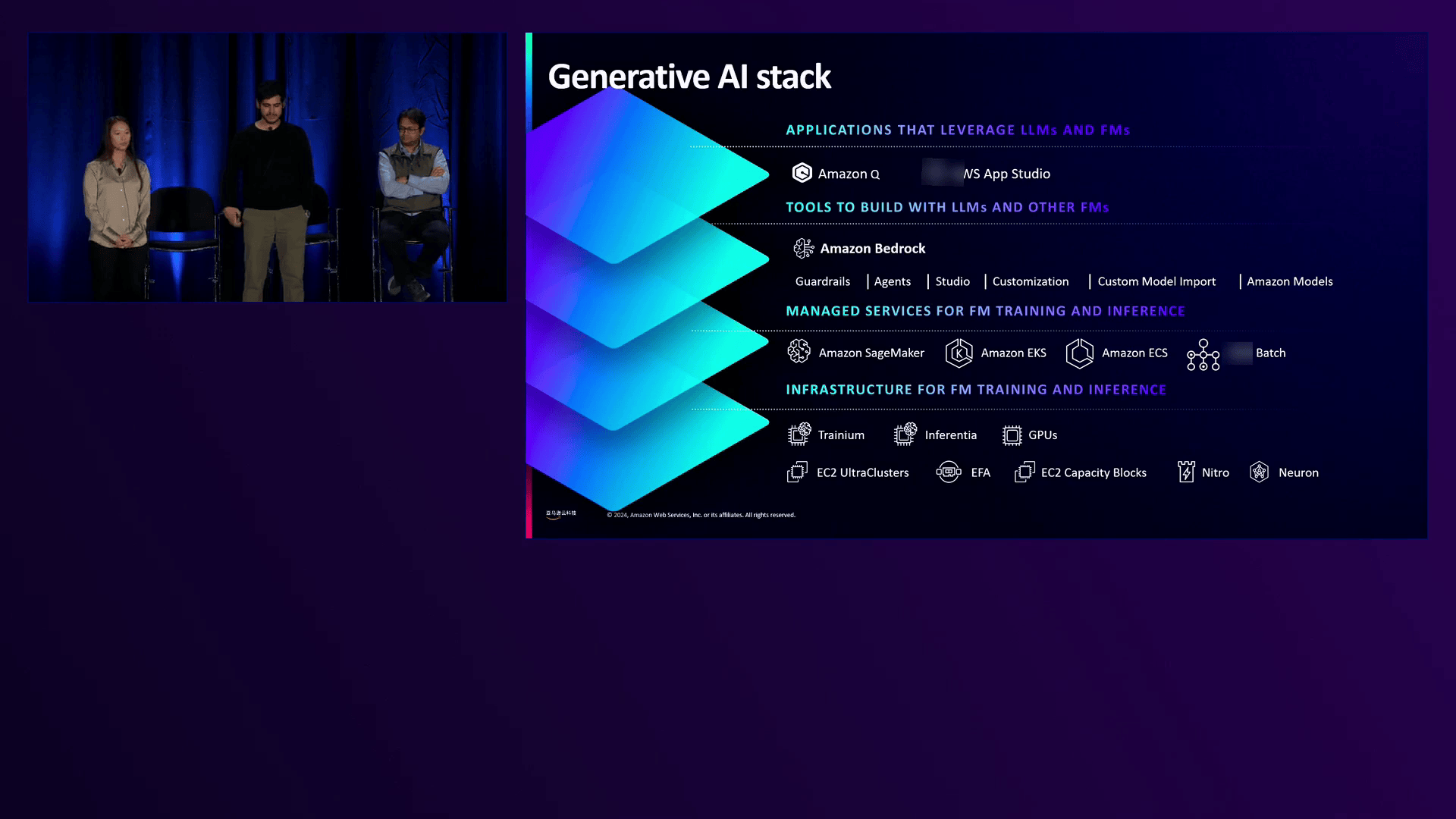

在生成式AI技术栈方面,AWS提供了包括SageMaker和Bedrock在内的多种工具和服务。SageMaker提供了端到端的托管服务,帮助客户准备数据、训练模型和部署应用。Bedrock则简化了对预训练语言模型的微调和部署过程。

在re:Invent大会上,meta分享了其利用AWS开发Ray-Ban meta智能眼镜的经验。该眼镜集成了meta AI功能,能够通过视觉和听觉输入为用户提供实时反馈。meta利用AWS的计算能力和可靠性,快速原型设计和扩展其多模态LLM。

AWS在加速计算和生成式AI领域的不断创新,为全球企业和开发者提供了强大的支持。随着生成式AI技术的不断发展,AWS将继续引领这一领域的进步,推动各行各业实现数字化转型和智能化升级。

AWS通过其全面的计算实例组合、强大的托管服务和创新的技术栈,为客户提供了构建和扩展生成式AI模型的高效解决方案。随着生成式AI技术的不断成熟和应用场景的不断拓展,AWS将继续发挥其全球领先的云计算优势,为客户创造更大的价值。