在AI领域,一场由DeepSeek引领的风暴正席卷全球。自去年12月26日DeepSeek AI发布其最新大型语言模型DeepSeek-V3以来,AI界便为之震动。这款拥有6710亿参数的MoE架构模型,每秒能处理60个token,处理速度是V2版本的三倍,迅速成为业界的焦点。

紧接着,在今年1月20日,DeepSeek再推重磅产品——推理大模型DeepSeek-R1,再次惊艳业界。短短数日内,DeepSeek应用便登顶苹果中国区和美国区应用商店免费App下载排行榜。1月31日,英伟达、亚马逊和微软三大科技巨头同日宣布接入DeepSeek-R1,进一步彰显了其市场影响力。

DeepSeek-V3与DeepSeek-R1-Distill蒸馏模型各自拥有独特的定位。DeepSeek-V3擅长处理复杂任务和高精度场景,如长文档分析、多模态推理、科研计算等,支持千卡级训练,满足超大规模集群分布式训练需求。而DeepSeek-R1-Distill蒸馏模型则更适合轻量级部署和资源受限场景,如边缘设备推理、中小企业快速验证AI应用,对显存和算力要求更为灵活,适配入门级硬件。

据硅谷顶尖风险投资家Marc Andreessen发文引用SensorTower数据,目前DeepSeek日活用户数已达到ChatGPT的23%,应用每日下载量接近500万。2月5日,京东云宣布正式上线DeepSeek-R1和DeepSeek-V3模型,支持公有云在线部署、专混私有化实例部署两种模式。此前,阿里云、百度智能云、华为云、腾讯云、火山引擎、天翼云以及海外的亚马逊AWS、微软Azure等云巨头也已接入DeepSeek模型。

DeepSeek之所以受到广大用户的青睐,主要得益于其两大优势:低成本与高效能,以及开源与灵活部署。在低成本与高效能方面,DeepSeek-V3的训练成本仅为557.6万美元,约为GPT-4的二十分之一,却能在逻辑推理、代码生成等任务中达到与GPT-4、Claude-3.5-Sonnet相近的性能,甚至超越部分开源模型。其技术核心在于算法优化和数据效率提升,而非依赖算力堆叠。相比之下,GPT-5一次为期6个月的训练成本就高达约5亿美元。

在开源与灵活部署方面,DeepSeek选择将模型权重开源,并公开训练细节,这为全球的AI研究者打开了通往模型内部的大门。360集团创始人周鸿祎指出,DeepSeek真正践行了开放的精神,与OpenAI等封闭模式平台相比,DeepSeek允许开发者利用其开源模型进行技术挖掘和创新,这是对技术共享理念的有力支持。周鸿祎还特别提到DeepSeek的模型蒸馏技术,认为其展示了DeepSeek的自信与无私。

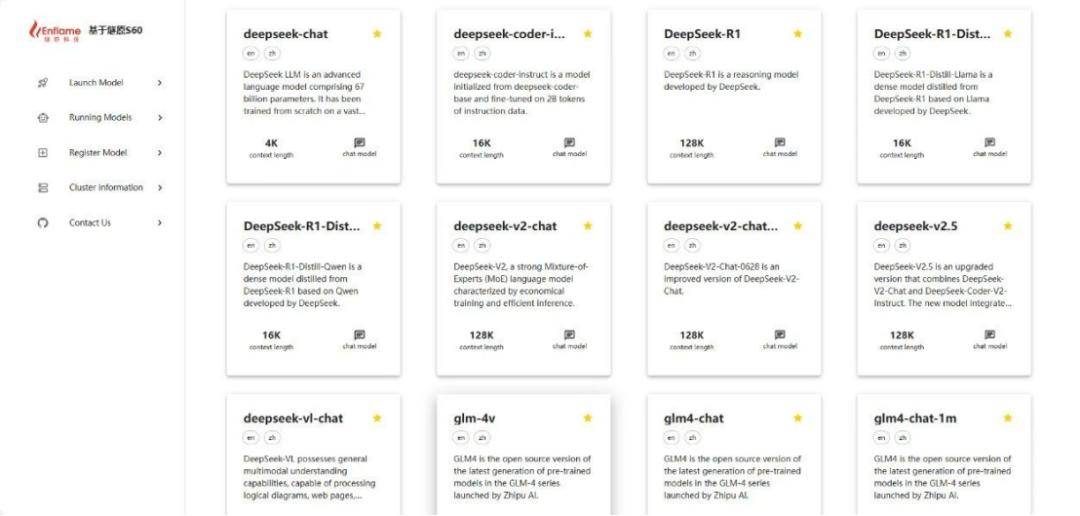

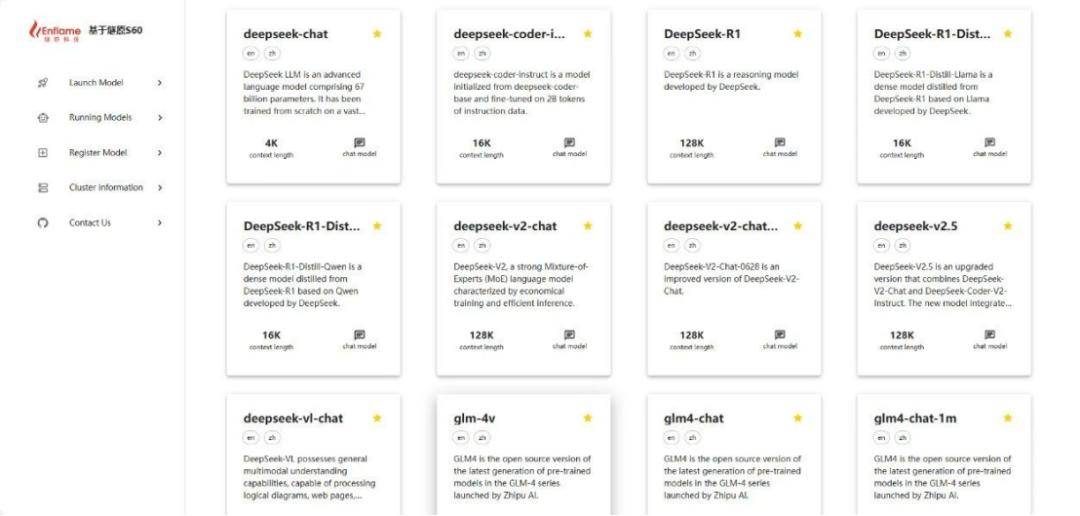

随着DeepSeek这类模型的发展,对GPU需求持续攀升。国产GPU厂商也敏锐捕捉到这一机遇,积极进行适配工作。仅在2月1日至2月7日这短短7天内,就有11家国产AI芯片公司宣布完成对DeepSeek的适配。包括摩尔线程、海光信息、天数智芯、壁仞科技、云天励飞、太初元碁、燧原科技、昆仑芯、龙芯中科等在内的多家企业,纷纷宣布对DeepSeek模型的适配和支持。

DeepSeek的横空出世,不仅打破了AI领域的高昂成本壁垒,更为国产芯片公司带来了新的发展契机。随着大模型应用的普及,对芯片的需求水涨船高。DeepSeek与国产AI芯片的适配逐步成熟,为国产芯片提供了一个更为契合的适配平台,加快了国产AI芯片在国内大模型训练端和推理端的应用。同时,DeepSeek与国产芯片的协同作用,将推动国产芯片在人工智能领域的应用,加速国产芯片生态体系的建设。