报告聚焦AI安全问题,探讨了AI在各阶段面临的安全挑战及应对策略,强调了多方协作保障AI安全的重要性。

1. AI安全的关键利益相关者:云计算服务提供商提供AI计算资源,负责审查供应商、管理权限和保障物理与网络安全;模型构建者开发训练AI模型,需采用安全设计方法、测试漏洞;企业负责人和运营者部署维护AI系统,要建立测试流程、保护数据隐私 。

2. AI安全在不同阶段的实践

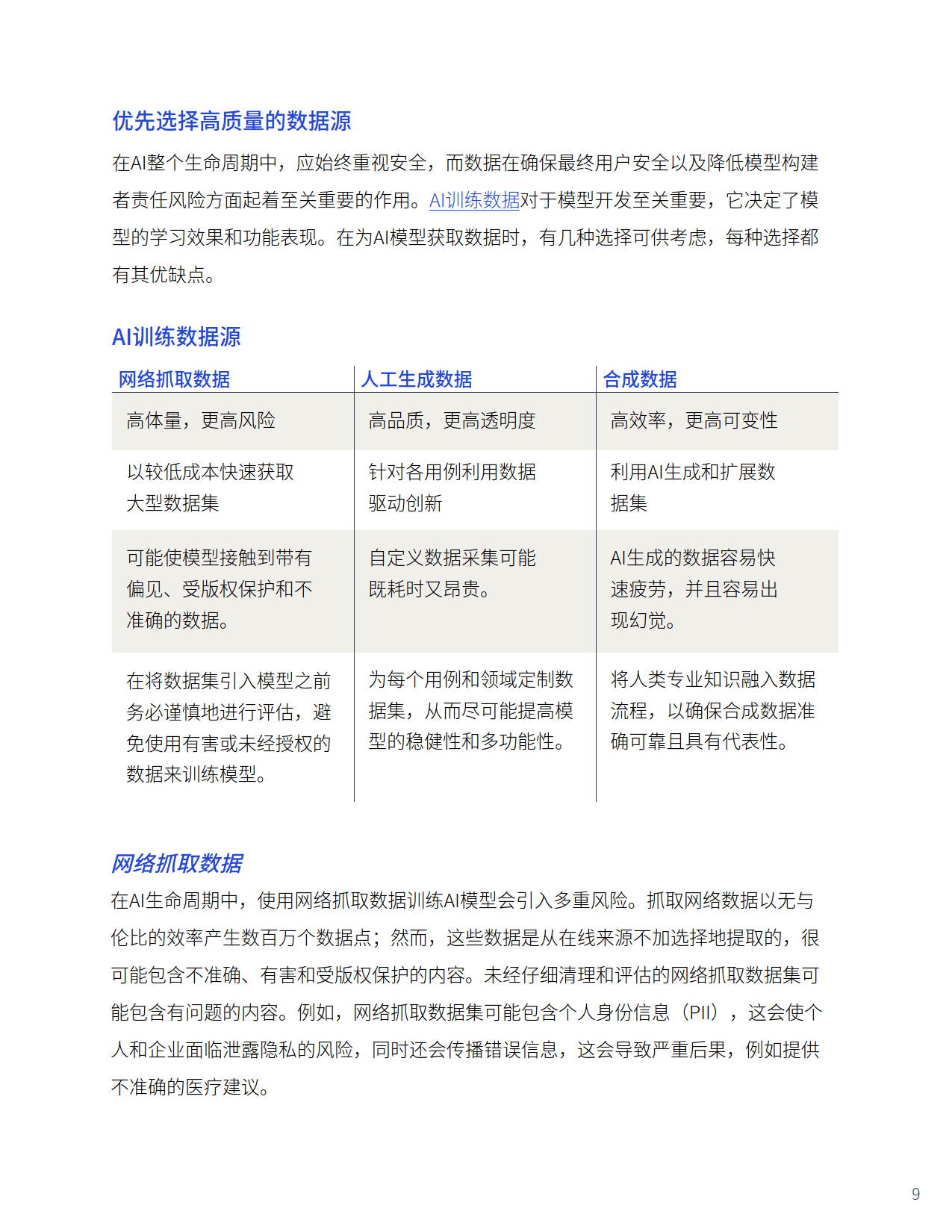

开发阶段:采用安全设计方法,全面评估风险,融入伦理考量,审查数据提供者,增强模型韧性并持续优化。同时,重视数据源选择,网络抓取数据虽获取便捷但存在版权、偏见等风险;人工生成数据质量高但成本高昂;合成数据经济高效但易疲劳,三者各有利弊,应结合使用并遵循数据管理最佳实践,如确保数据供应链透明、数据集具代表性、实现人机协作 。

部署阶段:建立监督与反馈机制至关重要。持续监督模型准确度,如监测社交媒体审核算法和汽车安全系统;构建透明反馈机制,像电商聊天机器人采集数据优化服务;严格审查模型行为,利用红队测试等技术检测漏洞。人机协同系统不可或缺,人工生成数据集、监督微调模型和人机协作标注数据,都有助于提升AI安全性 。

应用阶段:遵循AI安全准则,与第三方合作确保安全标准一致。减少算法偏见,使用高质量数据、持续改进模型并开展人机协同评估;实现可解释AI,便于排查问题和增强信任;制定伦理框架,参考领先框架确保AI符合伦理标准。在全球化背景下,多语言系统要考虑文化差异和法律要求,进行本地化部署和持续监控优化 。

3. 风险管理策略及行业示例:AI应用存在信息危害、武器化、有害内容输出和法律责任等风险。需持续测试监控模型、运用红队测试技术、开发筛选工具、采集合规数据来应对。在关键基础设施、教育、医疗、法律等行业,AI虽带来创新,但也面临数据偏见、系统错误、隐私保护和法律合规等挑战,需谨慎应对

4. AI安全需要各方共同努力,贯穿AI生命周期。通过实施安全措施和风险管理策略,可降低风险、推动创新,促进人类与智能系统间的信任,提升生活体验。